IA en médecine : des chercheurs appellent à une régulation face aux dérives possibles

L’introduction massive de l’IA en santé cache des angles morts majeurs sur la sécurité et la responsabilité des outils déployés. Un point d’étape essentiel pour tous les acteurs du secteur.

En bref

- ⚙️

Explosion des outils IA non contrôlés : De nombreux logiciels médicaux utilisant l’IA circulent sans validation réglementaire stricte, ce qui laisse leurs effets réels largement inconnus.

- 🔍

Risque juridique pour les praticiens : L’absence de cadre précis rend floue la responsabilité en cas d’erreur liée à l’IA et expose médecins et établissements à de lourds risques.

- 🧠

Appel à une régulation adaptée : Les experts demandent un encadrement robuste, incluant des évaluations indépendantes et un suivi réel, pour garantir la sécurité et la fiabilité des IA en santé.

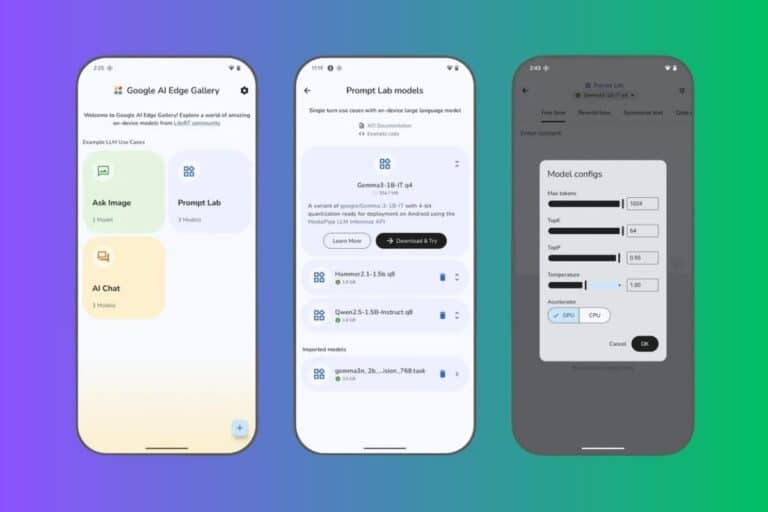

L’intelligence artificielle (IA) transforme la médecine à une vitesse fulgurante. Des outils d’aide au diagnostic aux applications d’imagerie médicale, elle s’immisce dans tous les recoins de la pratique quotidienne. Pourtant, cette adoption rapide soulève de sérieuses inquiétudes au sein de la communauté scientifique : où sont passées les évaluations rigoureuses et les régulations indispensables à la sécurité des patients ? Dans un article publié dans la prestigieuse revue JAMA, 52 chercheurs alertent sur les dangers d’un déploiement massif et mal encadré de l’IA dans le domaine de la santé.

Une révolution médicale aux multiples promesses

L’IA bouleverse déjà la médecine. Elle améliore le triage des patients aux urgences, renforce les performances de l’imagerie médicale, automatise la transcription des consultations et optimise les processus administratifs. Les avantages potentiels sont considérables : diagnostics plus rapides, meilleure prise en charge, optimisation des coûts. Mais comme le soulignent les chercheurs de JAMA, ces bénéfices s’accompagnent de risques tout aussi importants, notamment en l’absence d’évaluations fiables et indépendantes.

Des outils largement utilisés… mais rarement évalués

De nombreux outils d’IA sont aujourd’hui intégrés dans les dispositifs médicaux sans qu’ils ne soient soumis à une validation réglementaire stricte. La Food & Drug Administration (FDA) aux États-Unis ou l’ANSM en France ne supervisent pas toujours leur mise sur le marché, notamment lorsque les logiciels sont considérés comme de simples outils de soutien administratif ou d’aide à la décision. Résultat : les effets réels de ces outils, qu’ils soient bénéfiques ou dangereux, restent souvent inconnus, car les évaluations sont complexes, coûteuses et parfois non exigées par la loi.

🤖 Tu veux mettre l’IA au service de ton business ?

Rejoins la newsletter IA & automatisation Kavyro.

Chaque semaine : systèmes, cas concrets, gains de temps.

Un vide juridique qui inquiète les praticiens

Cette absence de régulation claire pose un problème majeur : la responsabilité en cas d’erreur. Si un diagnostic erroné est émis par un outil d’IA non évalué, qui doit en répondre ? Le médecin ? Le développeur ? L’établissement de santé ?

Comme l’explique Derek Angus, chercheur à l’Université de Pittsburgh, les praticiens redoutent d’être tenus pour responsables d’erreurs qu’ils n’ont pas commises directement. De plus, de nombreux hôpitaux n’ont ni les ressources financières ni les compétences techniques pour évaluer eux-mêmes ces technologies.

Une réglementation inadaptée aux réalités de l’IA

Le cadre réglementaire actuel n’est tout simplement pas conçu pour gérer les spécificités de l’IA. Aux États-Unis, les logiciels sont souvent exclus de la définition légale de « dispositif médical », ce qui permet à certains outils d’aide au diagnostic d’échapper aux contrôles. Une fois commercialisés, ils peuvent être utilisés dans des contextes très variés, par des professionnels aux niveaux de compétences hétérogènes, sans garantie que leurs performances restent conformes aux attentes initiales.

Vers une gouvernance plus stricte et plus protectrice

Face à ces constats, les chercheurs appellent à la mise en place d’un cadre réglementaire robuste et adapté. L’objectif : protéger les patients, garantir la crédibilité des outils d’IA et s’assurer qu’ils tiennent leurs promesses en matière de santé publique. Cela implique non seulement des évaluations rigoureuses avant mise sur le marché, mais aussi un suivi continu de leurs effets réels en conditions cliniques. Les points de vue des patients et des communautés concernées doivent également être davantage intégrés dans ce processus.

- Enjeux IA santé & régulation 2025 (Groupe IMT)

- Stratégie France IA santé 2025 (Delsol Avocats)

- IA et dispositifs médicaux en France (Roche Pro)

Rédactrice web pour Kavyro, je vous aide à décrypter l’actualité IA et automatisation, simplement et sans jargon. Pour me contacter : [email protected]